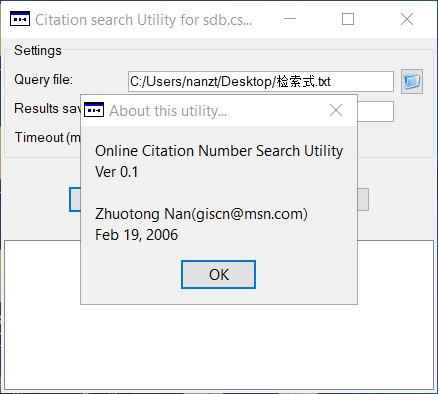

Zhuotong Nan ([email protected])

以下简单的代码实现了ArcGIS支持的栅格向Golden software的Surfer ASCII grid的格式转化。需要注意的是,ArcGIS的栅格左上为坐标原点,向下向右为正。而Surfer grid是左下是坐标原点,向上向右为正。

Here I will show a class that implements the major functionality to convert any Raster file supported by ArcGIS to Surfer ASCII grid format. The resulting Surfer grid can be read by Surfer with version 6 or higher. One point we need to keep in mind, ArcGIS raster stores data in row-major order, right and downwards being positive, while Surfer grid takes lower left corner as the original, right and upwards being positive.

using System;

using System.Collections.Generic;

using System.Text;

using System.IO;

using ESRI.ArcGIS.Geodatabase;

using ESRI.ArcGIS.DataSourcesRaster;

using ESRI.ArcGIS.esriSystem;

using ESRI.ArcGIS.Geometry;

namespace RasterToSurferGrid

{

/// <summary>

/// A wrapper class for Surfer ASCII grid file

/// </summary>

class SurferGrid

{

string id = “DSAA”;

int nx;//columns

int ny; //rows

double xlo; //the minimum X value of the grid

double xhi; //xhi is the maximum X value of the grid

double ylo;

double yhi;

double zlo;

double zhi;

List<double> data; //the grid is stored in row-major order, with the lowest row (minimum Y) first

public SurferGrid(string rasterPath)

{

data = new List<double>(nx * ny);

IWorkspaceFactory wf = new RasterWorkspaceFactoryClass();

IRasterWorkspace wk=(IRasterWorkspace)wf.OpenFromFile(System.IO.Path.GetDirectoryName(rasterPath), 0);

IRasterDataset ird = wk.OpenRasterDataset(System.IO.Path.GetFileName(rasterPath));

IRaster raster=ird.CreateDefaultRaster();

IRasterProps props = (IRasterProps)raster;

nx = props.Width;

ny = props.Height;

IEnvelope env = props.Extent;

xlo = env.XMin;

xhi = env.XMax;

ylo = env.YMin;

yhi = env.YMax;

//zlo = env.ZMin;

//zhi = env.ZMax;

//populate data

PntClass extent=new PntClass();

extent.X=nx;

extent.Y=ny;

IPixelBlock datablock=raster.CreatePixelBlock(extent);

PntClass orig = new PntClass();

orig.X = 0;

orig.Y = 0;

raster.Read(orig, datablock);

for (int y = ny – 1; y >= 0; y–)

//for (int x = 0; x < nx; x++)

{

for (int x = 0; x < nx; x++)

{

data.Add((float)datablock.GetVal(0,x,y));

}

}

//get the max, and min

double max, min;

max = data[0]; min = data[0];

for (int i = 0; i < data.Count; i++)

{

max = max > data[i] ? max : data[i];

min = min < data[i] ? min : data[i];

}

zlo = min;

zhi = max;

}

public void WriteToFile(string outPath)

{

//StringWriter sw = new StringWriter();

StreamWriter sw = new StreamWriter(outPath);

sw.WriteLine(id);

sw.WriteLine(“{0} {1}”, nx, ny);

sw.WriteLine(“{0} {1}”, xlo, xhi);

sw.WriteLine(“{0} {1}”, ylo, yhi);

sw.WriteLine(“{0} {1}”, zlo, zhi);

StringBuilder sb=new StringBuilder();

for (int i = 0; i < ny; i++)

{

for (int j = 0; j < nx; j++)

{

sb.AppendFormat(“{0} “, data[i*nx+j]);

}

sb.Remove(sb.Length – 1, 1);

sb.AppendLine();

}

sw.Write(sb.ToString());

sw.Close();

}

}

}

附件是源代码。工具的运行需要dotnet framework 2.0和ArcView以上的License运行。编译后在命令行敲入RasterToSurferGrid有使用提示。

The attached please find necessary source codes which can be compiled on your own platform. Dotnet framework 2.0 and a valid ArcView license or higher are both required to run this tool. Besides, ArcGIS assemblies for dotnet framework are required. After successful compilation, typing RasterToSurferGrid following the command prompt shows you its usage information.

RasterToSurferGrid.zip